A Padova il primo robot controllato dai bambini con il pensiero

padovaoggi.it

Un team di ricercatori del laboratorio Intelligent Autonomous Systems (Ias-Lab) del dipartimento di ingegneria dell’informazione dell’Università di Padova ha coinvolto per la prima volta cinque bambini tra 8 e 12 anni in un esperimento di neurorobotica, basato su un sistema Brain Computer Interface al fine di dimostrare che anche il cervello di un bambino può controllare un robot con la forza del pensiero. L’automa utilizzato nell’esperimento è il robot umanoide Pepper, adottato qualche anno fa dalla Pediatria di Padova.

Pepper: il robot umanoide che gioca con i bambini

Pepper, il robot umanoide di Aldebaran Robotics (azienda di robotica che adesso ha cambiato il suo nome in Softbank Robotics) è uno dei primi robot da compagnia al mondo ad avere portato la robotica e l’intelligenza artificiale nelle abitazioni. Pepper è un social robot che parla e comprende il linguaggio umano, un automa che percepisce le tue emozioni e agisce di conseguenza. È in grado di riconoscere se sei contento o triste, se ti sorprendi per qualcosa o se sei arrabbiato, analizzando il tono della tua voce, la posizione della testa e la postura che assumi mentre parli. Pepper è in grado di interagire con gli amici umani anche attraverso un tablet che si trova all’altezza del torso ed è connesso sempre a Internet: ciò gli consente, quando ne hai bisogno, di suggerirti una ricetta, di tenerti informato su cosa è successo nel mondo nelle ultime ore e sulle previsioni del tempo.

Alto un metro e venti, è dotato di tre ruote multidirezionali, grazie alle quali può muoversi in tutte le direzioni a una velocità massima di tre chilometri orari, e di un complesso di 20 motori che gli consentono di muovere testa, braccia e schiena. Grazie a quattro microfoni direzionali che ha nella sua testa, è in grado di rilevare la provenienza di suoni e voci e girare la faccia in direzione di chi sta parlando. Questi microfoni gli consentono anche di analizzare il tono della tua voce per interpretare il tuo stato emotivo. Una fotocamera 3D e due telecamere HD gli permettono di riconoscere invece immagini, oggetti e volti.

L’esperimento allo Ias-Lab: per la prima volta sono coinvolti i bambini

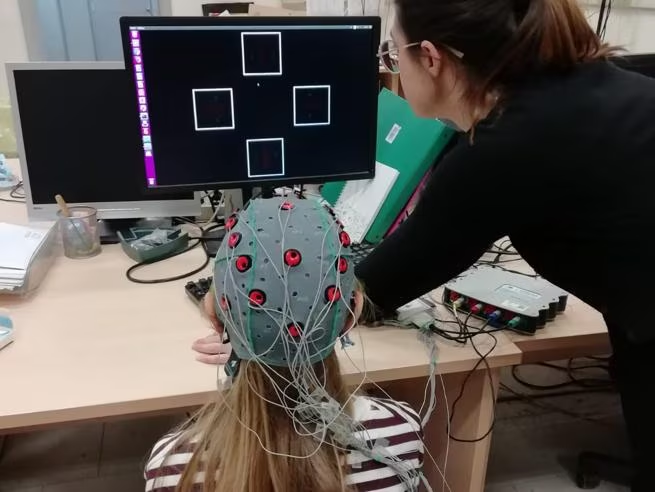

Durante l’esperimento i bambini coinvolti hanno indossato un caschetto dotato di elettrodi in grado di digitalizzare i segnali elettrici del cervello, che vengono successivamente elaborati da un software; questo consente di stabilire quale area del cervello è stata attivata e a quale comando corrisponde. La tecnica implementata dai dottorandi dello Ias-Lab e testata sui bambini, consiste nel riconoscimento di un evento che il bambino sta aspettando. Il bambino è posto davanti a un monitor con quattro scelte lampeggianti, associate a quattro comandi come avanti, indietro, destra e sinistra; quando lampeggia quella preferita, il cervello del bambino genera un’onda facilmente riconoscibile.

Grazie a questo sistema i bambini hanno controllato il robot Pepper con il pensiero, facendo spostare l’umanoide all’interno del laboratorio. I movimenti avvengono sulla base di un paradigma che consente al robot di evitare gli ostacoli anche quando il bambino non riesce a inviare i comandi», spiega Menegatti. «Controllare la traiettoria di un robot come quella di una macchinina telecomandata vorrebbe dire inviare comandi in continuazione, e sarebbe troppo faticoso mentalmente: il robot deve ricevere pochi comandi e interpretarli correttamente, percorrendo sempre la stessa distanza a ogni comando o avanzando a velocità costante finché non riceve un comando nuovo».

Il fatto di aver coinvolto i bambini in questo genere di studio rappresenta un traguardo particolare e fuori dall’ordinario. Infatti, benché questo filone di ricerca esista da circa trenta anni, finora era stato validato solo con gli adulti, sia perché coinvolgere i bambini in esperimenti di laboratorio è molto complicato dal punto di vista burocratico, sia perché il cervello dei bambini è ancora poco conosciuto, e c’è un certo scetticismo sulla loro capacità di concentrazione durante l’utilizzo di un’interfaccia cervello-macchina. I bambini coinvolti nell’esperimento hanno invece usato lo stesso software degli adulti, modificato solamente in un parametro, dimostrando un notevole coinvolgimento emotivo, che ha fatto funzionare il sistema anche meglio.

Prospettive future

Lo studio condotto pone le basi per una sperimentazione clinica più ampia, guidata dalla professoressa Agnese Suppiej, presso l’Università di Ferrara. L’obiettivo è quello di captare i segnali cerebrali dei bambini in paralisi totale, magari solo temporanea come conseguenza di un trauma, che non possono muovere nemmeno gli occhi ma hanno conservato capacità cognitive intatte e che, quindi, sono prigionieri nel loro corpo. Se un bambino con paralisi completa riuscisse a controllare grazie alla forza del pensiero un robot, quest’ultimo potrebbe diventare il suo avatar- assistente in grado svolgere una sorta di semplici ma essenziali azioni abituali come chiudere la porta, alzare una tapparella, accendere la luce. Insomma, una piccola indipendenza in più,ma un grande canale di comunicazione con il mondo circostante.